在当今信息爆炸的时代,数据作为驱动决策的重要资源,其准确性、时效性和完整性对于企业和个人而言至关重要,特别是在金融投资、市场分析等领域,快速获取并处理最新数据成为制胜的关键。“抓码王”作为一种自动化数据采集工具,凭借其高效、智能的特点,在众多应用场景中脱颖而出,本文将从技术原理、实现方式、实际应用及优化策略等方面,深入探讨抓码王自动更新机制的科学解答与实践探索。

一、引言

随着大数据技术的不断发展,数据采集作为数据分析流程中的第一步,其效率和质量直接影响到后续数据处理与分析的效果,传统的手动采集方式不仅耗时耗力,且难以保证数据的实时性和全面性,自动化数据采集工具如抓码王应运而生,它们通过模拟人类浏览网页的行为,自动抓取互联网上的公开数据,极大地提高了数据采集的效率和准确性。

二、抓码王自动更新的技术原理

抓码王的自动更新机制主要依赖于以下几个关键技术:

1、网络爬虫技术:这是抓码王的核心,通过编写特定的算法,模拟浏览器行为,向目标网站发送HTTP请求,下载网页内容,爬虫会根据预设的规则,解析HTML文档,提取所需的数据。

2、定时任务调度:为了实现数据的自动更新,抓码王通常结合定时任务调度器(如Cron作业、Windows任务计划程序等),按照用户设定的时间间隔,定期执行数据采集任务。

3、数据存储与管理:抓取的数据需要被妥善保存和管理,抓码王支持多种数据库系统(如MySQL、MongoDB等)或文件格式(如CSV、JSON等),便于数据的查询、分析和备份。

4、动态适应能力:面对网页结构的变化,高级的抓码王工具具备一定的自适应能力,通过机器学习或规则调整,能够在一定程度上自动应对网页布局的变动,减少维护成本。

三、实现方式与步骤

1、需求分析:明确需要抓取的目标网站、数据类型、更新频率等需求。

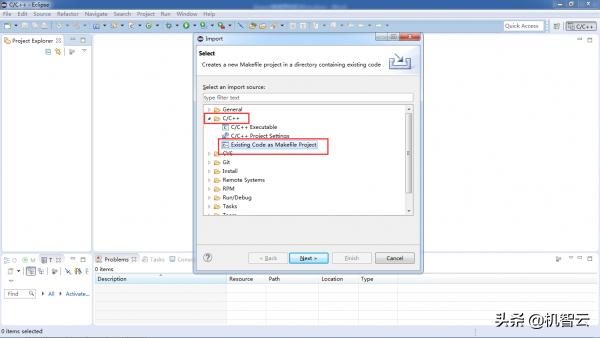

2、环境搭建:选择合适的开发环境和编程语言(如Python、Java等),安装必要的库和框架(如Scrapy、BeautifulSoup等)。

3、编写爬虫脚本:根据目标网站的结构,编写爬虫逻辑,包括URL管理、页面下载、内容解析、数据存储等功能模块。

4、设置定时任务:利用操作系统自带的任务调度器或第三方工具(如Apache Airflow),设置数据采集任务的执行时间和频率。

5、测试与优化:在实际运行前进行充分测试,确保数据抓取的准确性和稳定性,根据测试结果调整爬虫参数,优化性能。

6、监控与维护:部署后持续监控爬虫运行状态,及时处理异常情况,并根据网站变化调整爬虫逻辑。

四、实际应用案例分析

以金融数据分析为例,抓码王自动更新机制可以应用于股票市场价格监控、新闻舆情分析、社交媒体情绪分析等多个场景,通过定时抓取证券交易所的公开数据,结合自然语言处理技术分析财经新闻和社交媒体上的讨论,可以为投资者提供实时的市场动态和情绪指标,辅助投资决策。

五、面临的挑战与解决方案

1、反爬措施:许多网站采取了各种反爬措施,如IP封锁、验证码验证等,解决方案包括使用代理IP、模拟浏览器行为、设置合理的访问间隔等。

2、数据质量:自动抓取的数据可能存在噪音或错误,通过数据清洗、去重、校验等步骤提高数据质量。

3、法律与伦理问题:遵守相关法律法规,尊重数据所有权,避免侵犯隐私或版权。

六、总结与展望

抓码王自动更新机制作为现代数据采集技术的重要组成部分,极大地提升了数据处理的效率和智能化水平,随着人工智能、大数据技术的不断进步,抓码王将更加智能化,不仅能自动适应网页变化,还能更深入地理解数据背后的业务逻辑,为各行各业提供更加精准、高效的数据支持,随着数据隐私保护意识的增强,如何在保证数据利用效率的同时,兼顾个人隐私和数据安全,将成为抓码王及相关技术发展的重要方向。

转载请注明来自有只长颈鹿官网,本文标题:《抓码王 自动更新,科学解答解释落实_uq30.83.88》

京公网安备11000000000001号

京公网安备11000000000001号 京ICP备11000001号

京ICP备11000001号